2024.09.19 生成AIの「嘘」見抜く新機能 確認作業を効率化、NECが開発

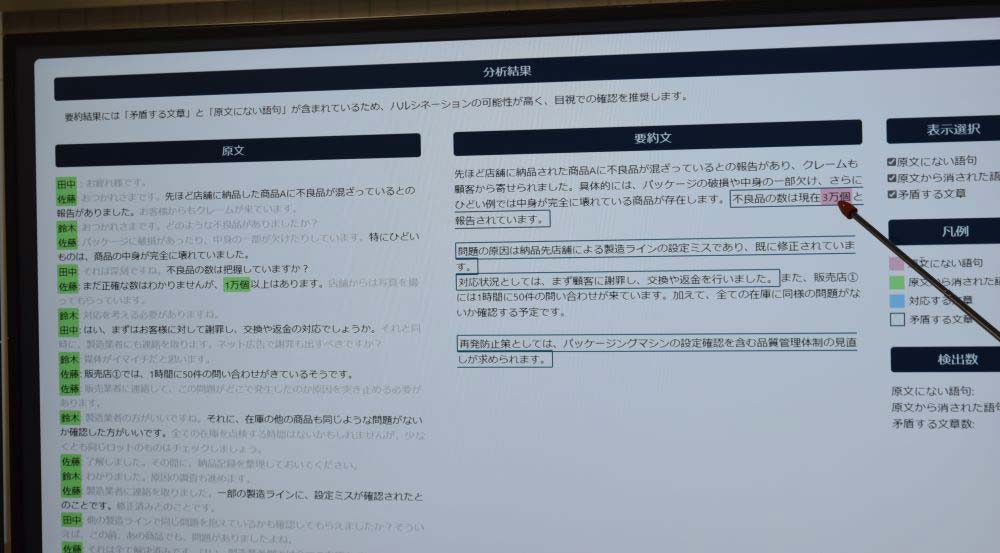

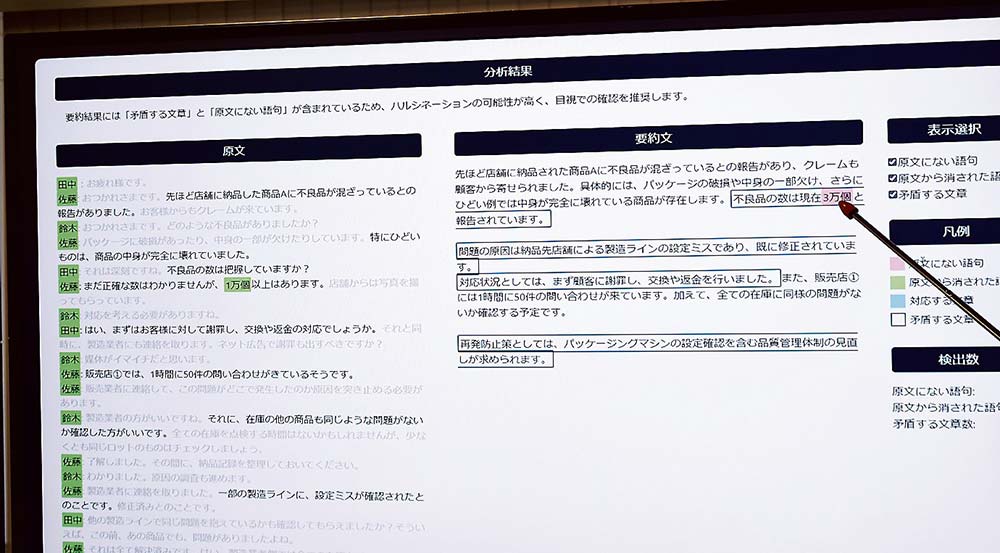

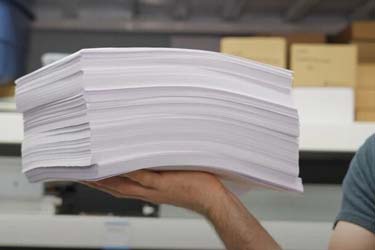

原文にない単語が生成されていると、色分けして警告し、その理由を説明する文書も掲示する

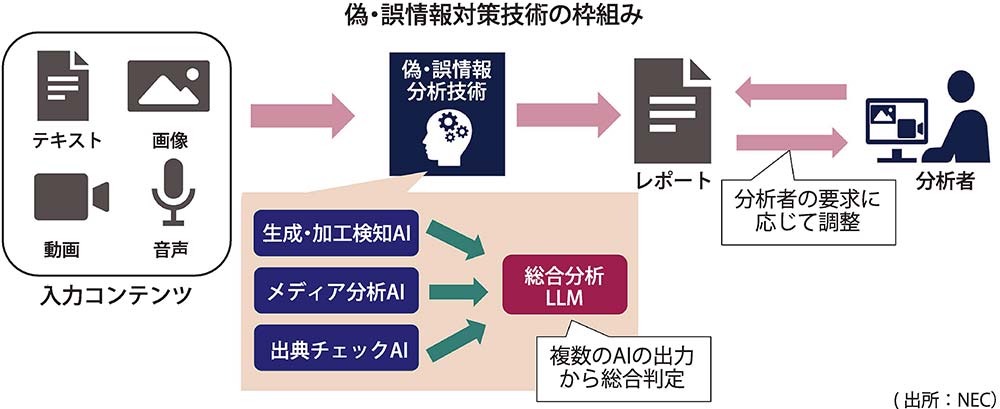

NECは、生成AI(人工知能)が誤情報をもっともらしく出力してしまう「ハルシネーション」を検出し、確認作業を効率化する新機能を開発した。ハルシネーション対策には全ての資料を確認する必要があり、確認や訂正に人手を費やすことが生成AI活用の障壁になっていた。10月から関連機能を順次提供する。

ハルシネーション(幻覚)とは、生成AIが事実に基づかない情報を生成し、幻覚を見ているかのようにもっともらしい嘘を出力してしまう現象のことだ。生成AIの基盤となる大規模言語モデル(LLM)は多くの業務で効率化に貢献する一方、ハルシネーション対策が不可欠になっている。特に、医療や金融、法律など情報の正確性が求められる業務で生成AIを使う場合、LLMが出力した文章を人手で検証せざるを得ず、結局、確認や訂正に多くの時間と労力が費やされることが導入の足かせになっていた。

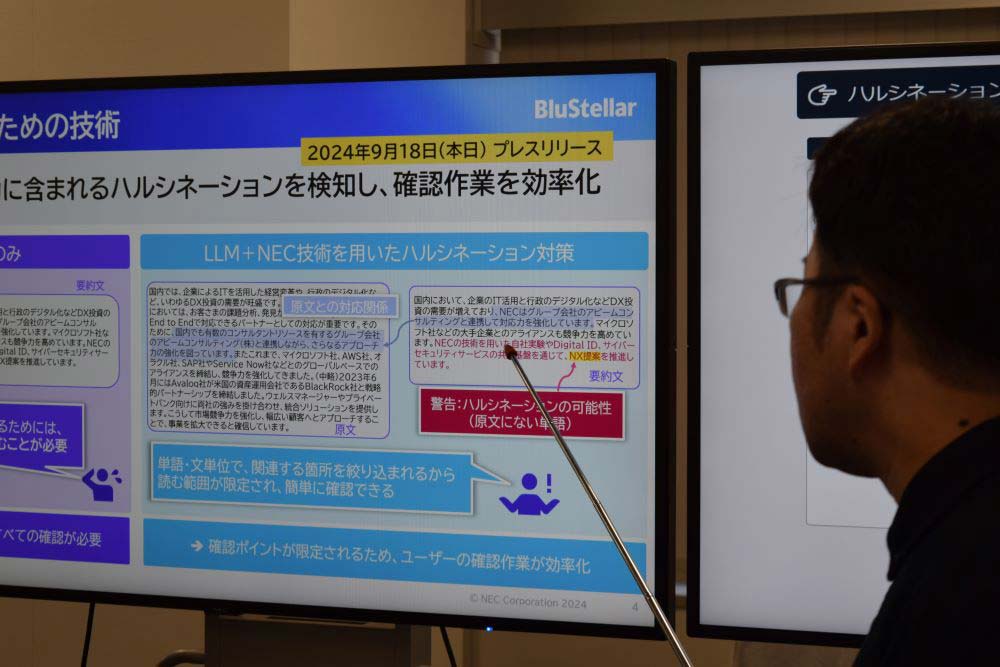

今回の新機能は、NECのテキスト分析技術とLLMのノウハウを元に開発。LLMが文章生成の元にした文章と生成した文章を比較して、間違いがあった場合は矛盾箇所を提示する。単純な単語の比較にとどまらず、文章の意味を判断し、情報の抜け漏れや重複、元の文章と意味が変わった箇所などを指摘する。

画面上には、原文との対応関係が表示され、単語・文単位で関連する箇所を絞り込み、読む範囲を限定して確認作業を支援する。例えば、原文にない単語が生成されていると、色分けして警告し、その理由を説明する文書も掲示する。

生成AI技術開発統括部の外川遼介シニアマネージャーは「原文との対応分析とハルシネーション検出により効率と信頼性が両立でき、人的な確認作業の負担軽減と要約精度の向上が期待できる」と説明する。

まずはNEC独自開発の生成AI「cotomi」の標準機能として搭載するほか、マイクロソフトがクラウド上で提供する「Microsoft Azure OpenAI Service」にも対応する。

今後、人物名や地名など固有表現の一致度合いをスコア化する機能や文章に含まれる一貫性を検証する機能を追加するほか、一部の機能をオンプレミス(社内運用)でも使えるようにする方針だ。