2026.01.21 ソフトバンク、AIデータセンター向けソフト基盤「Infrinia AI Cloud OS」開発 GPUとKubernetes運用を大規模自動化

「Infrinia AI Cloud OS」の主な特長

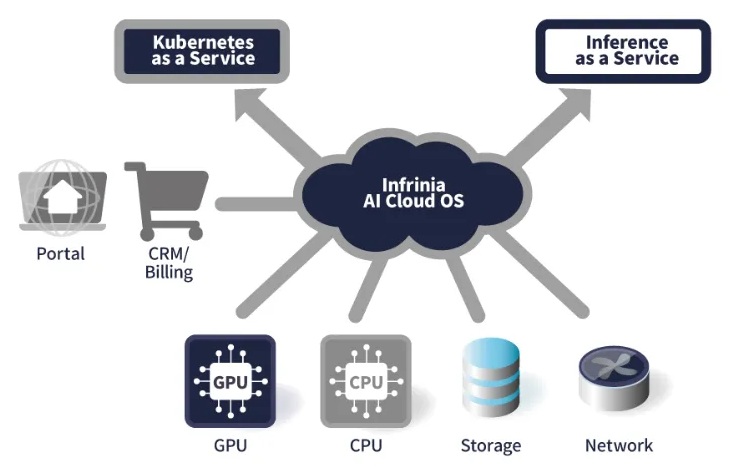

ソフトバンクは21日、AI(人工知能)データセンター向けのソフトウエアスタック「Infrinia AI Cloud OS」を開発したと発表した。GPU(画像処理半導体)やKubernetes(クラウド上のアプリ運用を自動化するオープンソース基盤)、AIワークロードを大規模に管理できる基盤で、AIデータセンター運営事業者の運用負荷低減と、GPUクラウドサービスの迅速な提供を支援する。

ソフトバンクによると、AIデータセンター運営事業者が同OS(基本ソフト)を導入することで、マルチテナント環境に対応したKubernetes as a Service(KaaS)と、大規模言語モデル(LLM)の推論機能をAPIとして提供するInference as a Service(Inf-aaS)を、自社GPUクラウドサービスの機能として構築できる。オーダーメードの導入や自社開発と比べ、TCO(総所有コスト)や運用負荷の低減が期待できるという。

開発の背景には、生成AIやロボティクス、シミュレーション、創薬、材料開発などGPUを活用したAI処理需要の急拡大がある。用途や利用形態が多様化・高度化する一方、GPUクラウドサービスの構築・運用には高度な専門知識と煩雑な作業が必要で、事業者側の負担が課題となっていた。同社はこうした課題を解決するため、GPUの性能を最大限に引き出しつつ、高度なGPUクラウドサービスの構築・運用を簡便かつ迅速に実現する基盤として同OSを開発した。

主な特長として、最先端GPU基盤上での各種設定からKubernetesやストレージ設定までの自動化により、物理インフラやKubernetesの運用負荷を低減する。AIワークロードの要件に応じて、クラスターの作成・更新・削除時に物理接続やメモリー構成を動的に再構成できる点も打ち出す。さらに、Kubernetesや基盤インフラを意識せずLLMを選択するだけで推論サービスを運用できるほか、OpenAI互換APIで既存AIアプリケーションの活用を容易にする。

このほか、暗号化されたクラスター通信とテナント分離による隔離機能を備え、モニタリングやフェールオーバーなど運用・保守作業の自動化も支援する。AIデータセンター事業者の管理画面や顧客管理、請求システムと連携するためのAPIも提供し、既存システムを持つ事業者がGPUリソースを柔軟に活用しながら高度な機能を自社サービスへ組み込めるようにする。

今後、ソフトバンクは自社GPUクラウドサービスへ同OSを導入する予定。Infriniaチームは海外のデータセンターやクラウド環境への展開を進め、グローバルでの普及を目指す。

宮川潤一社長兼CEOは「AIデータセンターから企業、サービスプロバイダー、開発者までをシームレスにつなぐ、次世代AIインフラのためのGPUクラウド基盤ソフトウエアである」とし、「AI時代のクラウド基盤を担い、社会に持続的な価値を提供していく」とコメントした。