2024.04.12 パワポのスライド丸わかり 文書画像理解する世界初の生成AI NTTが開発

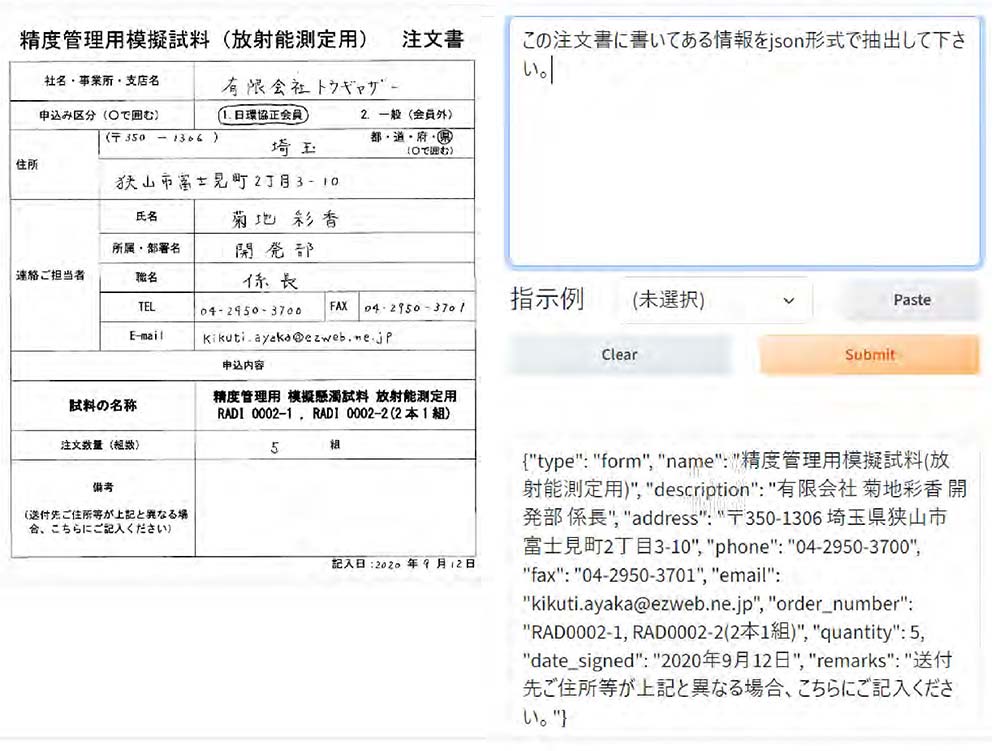

手書きの注文書(左)を読み取り、AIに指示を出すと文書画像を理解して回答を生成する

パワポのスライドを丸ごと理解する世界初の生成AIが登場する。NTTは12日、生成AI(人工知能)の基盤となる大規模言語モデル(LLM)が、図表を含めた文書画像を理解し自然言語での指示に応答する「視覚読解技術」を世界で初めて実現したと発表。文書に含まれるテキスト情報と視覚情報をLLMが理解できる形式に変換するアダプター技術を開発し、同社独自のLLM「tsuzumi(ツヅミ)」に採用した。

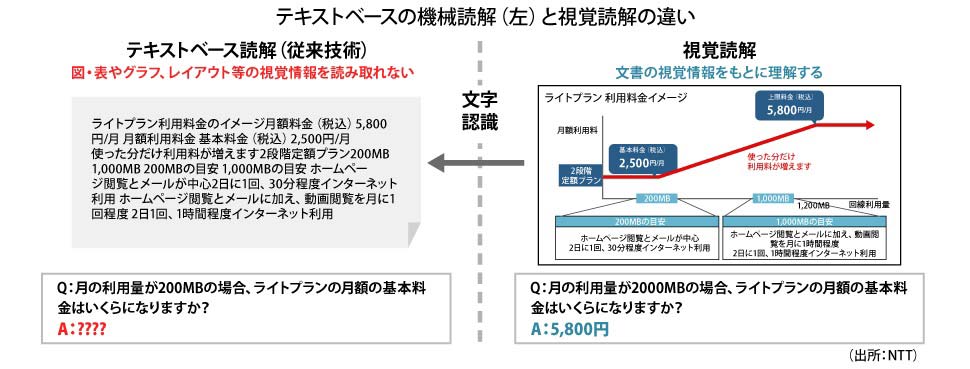

従来の生成AIは、システムが文書を知識源として参照しながら質問に回答する「機械読解技術」によって、関連する文書から該当箇所を取り出し、AIが回答してきた。読解できるのはテキストベースの文書に限られ、図表やグラフ、レイアウトなどの視覚情報を読み取ることができなかった。

これに対し視覚読解技術は、AIが実世界の文章を画像として視覚的に読解する。文書の視覚情報を基に読み取るため、ウェブページやPDF形式などさまざまなフォーマットに含まれる図表やグラフも理解できる。

ただ、これまでの視覚読解技術は、目的のタスクや文書ごとに一定数のサンプルを用意して学習する必要があるため、任意の文書やタスクに対応することが難しいのが課題だった。NTT人間情報研究所・思考処理研究プロジェクトの田中涼太研究員は「例えば請求書に対して情報抽出を行う場合、多くのサンプルを用意して学習する必要がある。全ての文書やタスクに対応するには大量のデータセットが求められるため、非現実的でコストもかかってしまう」と説明する。

そこでNTTは、LLMの推論能力を活用し、文書に含まれるテキスト、レイアウト、視覚情報を理解させるアダプター技術を構築。さまざまな視覚文書理解タスクをカバーする世界最大規模の画像を伴う指示文書によって、指示学習データセットを作成した。

視覚読解技術の実現により、手書きの注文書をアップロードして指示を出すと住所やメールアドレスなどを抽出するなど、紙の文書をスキャンしてデータ化することであらゆる文書についてAIが人間のように視覚から情報を理解できるようになる。田中研究員は「オフィスのデジタルトランスフォーメーションに資する重要技術となる」と期待を込める。

今回の技術はツヅミのアダプター技術に採用され、2024年度の商用利用開始を目指す。